车辆和行人检测技术是高级驾驶辅助系统(ADAS)和自动驾驶的最重要组成部分。毫米波雷达与摄像机的融合是提高环境感知性能的重要趋势。本文提出了一种基于毫米波雷达和摄像机的车辆和行人检测方法。此外,该方法基于雷达数据和滑动窗口算法生成的动态区域,完成了对车辆和行人的检测。首先,借助坐标变换将雷达目标信息映射到图像;然后通过分析场景,获得滑动窗口;再通过粗略检测通过HOG特征和SVM分类器检测滑动窗口;然后使用匹配功能确认目标;最终在精确检测中检测窗口并合并检测窗口。目标检测过程分为以下三个步骤:第一步是读取雷达信号并同时捕获摄像机数据,第二步是对数据进行构架和融合,第三步是检测目标并显示结果。通过实验证明,本文提出的融合算法能够更好地检测车辆和行人,为后续的目标跟踪研究提供依据。

简 介

在交通事故中,很大一部分事故是由追尾事故引起的,其中91%的追尾事故由驾驶员分心所致。因此,车辆和行人检测技术是高级驾驶辅助系统(ADAS)的重要组成部分,它可以用于准确识别前方的车辆和行人,在发生碰撞危险之前及时提醒驾驶员,避免交通事故的发生。

在车辆和行人检测中,使用单个传感器经常面临误检和漏检率高的问题。然而,对雷达和摄像机进行信息采集,实现数据融合,可以提高车辆和行人检测的速度和准确性。

在基于毫米波雷达和摄像机的车辆检测融合中,Shigeki Sugimoto等人完成了从雷达到摄像机坐标的转换,并在图像上标注了信息,但未做进一步的工作。Giancarlo Alessandretti等人,Trung-Dung Vu等人和li-sheng jin等人,JIN Lisheng 完成了融合算法并对车辆进行了测试,但对于雷达生成的区域没有进一步的研究。在基于毫米波雷达和摄像机融合的行人检测中,由于早期毫米波雷达检测行人的能力有限,因此很少进行研究。目前毫米波雷达可以满足行人检测的要求,并且可以与摄像机集成在一起进行行人检测。

为了弥补单传感器检测的不足,并详细研究雷达与摄像机融合检测,提出了一种雷达与摄像机融合的新方法。该算法使用雷达目标信息来确定由雷达数据在图像中生成的动态区域。然后通过分析场景来获得动态的滑动窗口。接下来,可以在粗略检测中通过HOG功能和SVM分类器测试滑动窗口。然后使用匹配功能确认目标。最终在精确检测中检测窗口并合并检测窗口。

坐标融合

坐标转换

雷达和摄像头是处于不同坐标系中的传感器。因此,为了实现传感器的空间融合,需要统一两个传感器的坐标。因此,有必要在雷达坐标系和图像像素坐标系之间建立过渡关系。

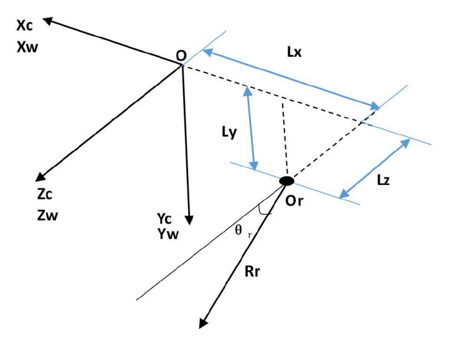

图1显示了毫米波雷达坐标系 OrRrθr ,相机坐标系 Oc-XcYcZc 和3D世界坐标系 Ow-XwYwZw 的相对位置。在本文中,我们设定世界坐标系与相机坐标系重合。

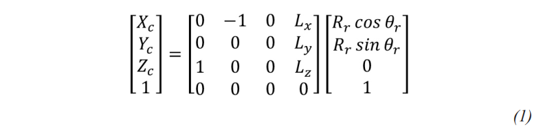

如图所示,毫米波雷达和摄像机的安装位置是固定的。因此,平面 OrRrθr 垂直于平面XcOc Zc 。因此,相机坐标系 P(Xc,Yc,Zc) 和雷达系统 P(Rr,θr) 的转换关系如下所示:

其中Lx,Ly,Lz是相机坐标系和雷达坐标系在三个方向上的距离。

图1. 三个坐标系的相对位置

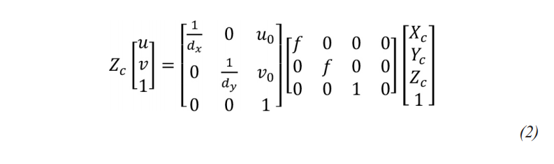

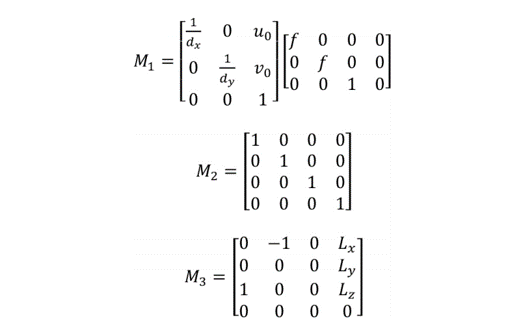

从摄像机坐标系 P(Xc,Yc,Zc) 到图像像素坐标系 (u,v) 的转换公式为:

在上式中,dx 和 dy 表示图像像素坐标系中X轴和Y轴上每个像素的物理长度,像素坐标(u0,v0)是光轴 Zc 与光轴 Zc 的交点。图像平面,f是相机的焦距。

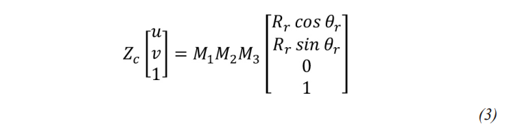

雷达坐标系与图像像素坐标系之间的转换关系可以通过公式(1)和公式(2)得到:

在上式中:

其中,M1是摄像机的内部参数矩阵,M2是从世界坐标系到摄像机坐标系的变换矩阵,M3是从雷达坐标系到世界坐标系的变换矩阵。

雷达数据生成的区域

雷达生成的区域用于与摄像机检测到的目标进行匹配。由于在雷达目标中,漏检率远低于虚警率,并且摄像机检测在目标检测方面具有更高的准确性,因此雷达生成区域内的摄像机目标检测在数据融合之后具有更好的可信度。

雷达信号预处理

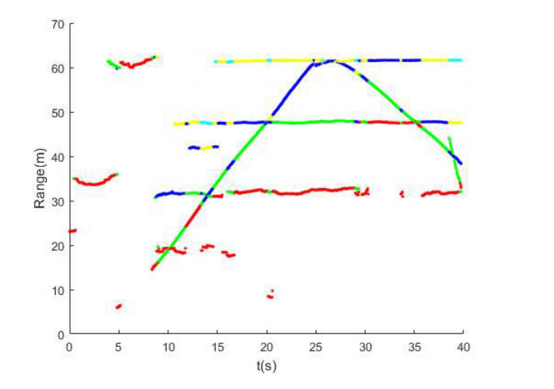

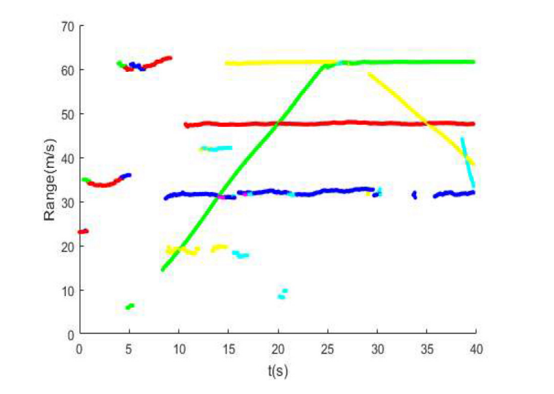

如图2所示,原始距离、速度和角度的图表可以通过绘制雷达输出目标距离随时间的原始数据来获得。同时,可以将雷达目标信号转换为图像并获得转换后的原始数据图。雷达目标信息可以连续输出目标的轨迹。同时,所有障碍物都将被输出,包括路边的护栏,电线杆,树木等。此外,还将输出一些虚假目标。

a. 雷达输出的原始距离数据。

图2 雷达输出的原始数据。

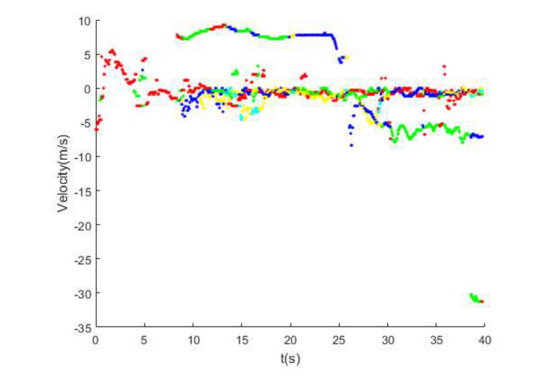

b. 雷达输出的原始速度数据。

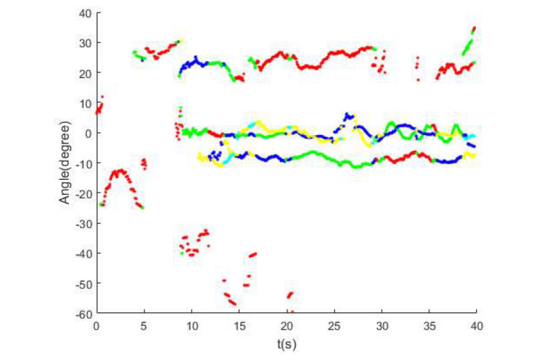

c. 雷达输出的原始角度数据。

图2(续). 雷达输出的原始数据。

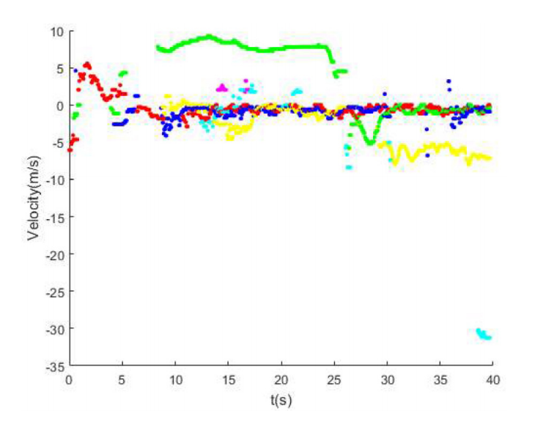

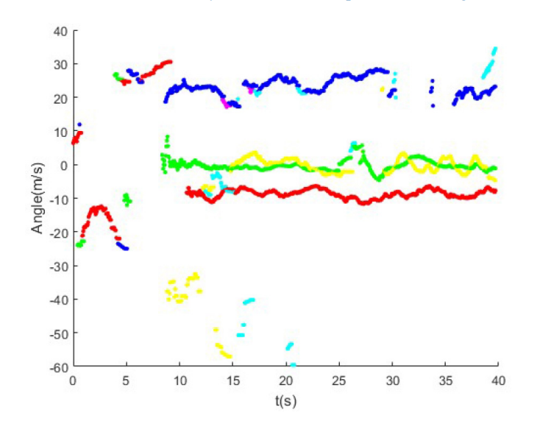

可以通过过滤和跟踪雷达数据来过滤掉错误目标。对于其他障碍,我们可以使用图像检测的方法进行判断。在对雷达数据进行跟踪滤波之后,可以获得目标信息的图形。图3显示了滤波后雷达的输出数据(包括范围、速度和角度)。将一个雷达周期的雷达信号转换为图像,将得到图4的融合图,图中的白色区域为变换后的区域。

a. 滤波后雷达输出的距离数据。

b. 滤波后用于雷达输出的速度数据。

c. 滤波后雷达输出的角度数据。

图3. 滤波后雷达输出的数据。

图4. 雷达与摄像机的融合图。

计算雷达数据生成的区域

雷达生成的区域的计算包括位置和区域大小。本文提出了一种通过认证来确定区域并考虑多种因素的新方法。

通过上一部分中的坐标变换将预处理雷达目标(Rr,θr) 映射到图像。然后可以在图像中获得相应的点O1。从理论上讲,该点位于图像中目标轮廓的中心,因此该点将用作雷达在车辆检测中生成的区域的中心。

考虑到实际安装,摄像机的水平角与车辆的侧倾角一致。将雷达在世界坐标系中生成的区域确定为矩形区域,以雷达目标为中心,并且该矩形区域垂直于垂直轴。

根据GB 159-2016,车辆轮廓的界限在宽Wm为2.55 m,在高Hm为4 m。此大小可以满足大多数汽车,卡车或其他车辆的检测要求。

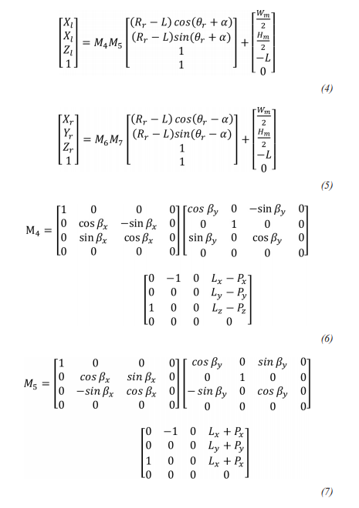

因此选择测试区域时应考虑雷达的角分辨率α,雷达测距分辨率L,雷达与世界坐标系之间的距离以及角度测量误差。

所选的测试区域如下:

其中βx,βy 表示相机坐标系和雷达系统之间 YcZc 和 ZcXc 平面中顺时针旋转角度的测量误差。 Px, Py, Pz 是3个方向上的测量误差。[X1 Y1 Z1],[Xr Yr Zr] 分别是相机坐标系中感兴趣区域的左下角坐标和右下角坐标。当考虑到由于雷达产生的区域中的左上角和中心之间的距离最远而导致的测量误差时,M4 是矩阵。当考虑到由于雷达产生的区域中的右上角和中心之间的最远距离而引起的测量误差时,M5 是矩阵。

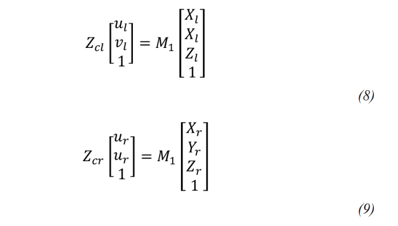

根据公式(2),雷达坐标系与图像像素坐标系之间的转换关系为:

其中 [ul νl],[ur νr] 是雷达在图像像素坐标系中生成的区域中的左上角和右下角的坐标。

获取由雷达数据生成的用于行人检测的动态区域的方法与确定由雷达生成的用于车辆检测的区域的方法相同。宽 Wp 中行人轮廓的上限大小为0.5m,高度 Hp 为2m。以相同的方式,通过坐标变换,可以在图像像素坐标系中得到行人检测雷达产生的区域。